Nous connaissons tous désormais, selon notre propre perception, l’intelligence artificielle ainsi que ses dérives, lesquelles s’avèrent malheureusement bien plus nombreuses que ses réels bénéfices. Les griefs sont multiples : qu’il s’agisse de sa consommation d’eau pharamineuse, de l’impact environnemental des datacenters sur leur voisinage immédiat, du remplacement prématuré et injustifié de travailleurs essentiels ou, plus récemment, de l’envolée des prix de la mémoire vive (RAM) au détriment de tout ce qui ne touche pas au domaine sacré des LLM.

IA de l’intelligence dans mon jeu ?

La définition de l’IA dans un jeu vidéo, c’est toujours un peu compliqué, le terme étant devenu un fourre-tout qui plait aux investisseurs. Oui on parle de l’IA d’un ennemi, oui on parle d’IA dans le DLSS, oui on parle d’IA avec Larian, spoiler : c’est très rarement lié aux LLMs. Nous avions déjà abordé la question du DLSS dans un article consacré à Borderlands 4 et à son déficit d’optimisation. Dans les faits, ce procédé permet aux développeurs de s’appuyer sur le deep learning pour booster les performances en jeu. Chouette !

Sur le fond, l’idée est effectivement séduisante : on améliore la fluidité d’un simple clic, les titres gourmands deviennent plus accessibles et les configurations PC modestes parviennent enfin à tenir la route. Mais cela ne reste vrai qu’en théorie. En pratique, si un studio peut réduire ses coûts de production, il ne s’en privera pas. Qu’il s’agisse du développeur indépendant cherchant à rentabiliser son projet ou de la firme AAA soumise à des impératifs de rentabilité, tous voient d’un bon œil cette économie d’échelle. Le revers de la médaille est la sortie de jeux moins optimisés, voire totalement instables, que l’on espère « sauver » artificiellement grâce aux outils de NVIDIA.

Car là réside le cœur du problème : le DLSS est une technologie propriétaire. Malgré l’existence du FSR ou du XeSS chez la concurrence, une question demeure : que se passera-t-il le jour où un titre ne sera plus compatible avec votre matériel ? Nous nous retrouvons désormais face à des jeux dont le fonctionnement dépend de systèmes internes contrôlés exclusivement par une entreprise tierce. Allons même plus loin, que se passera-t-il si une mise à jour brise tout le DLSS pendant un temps ?

La production qui RAM…

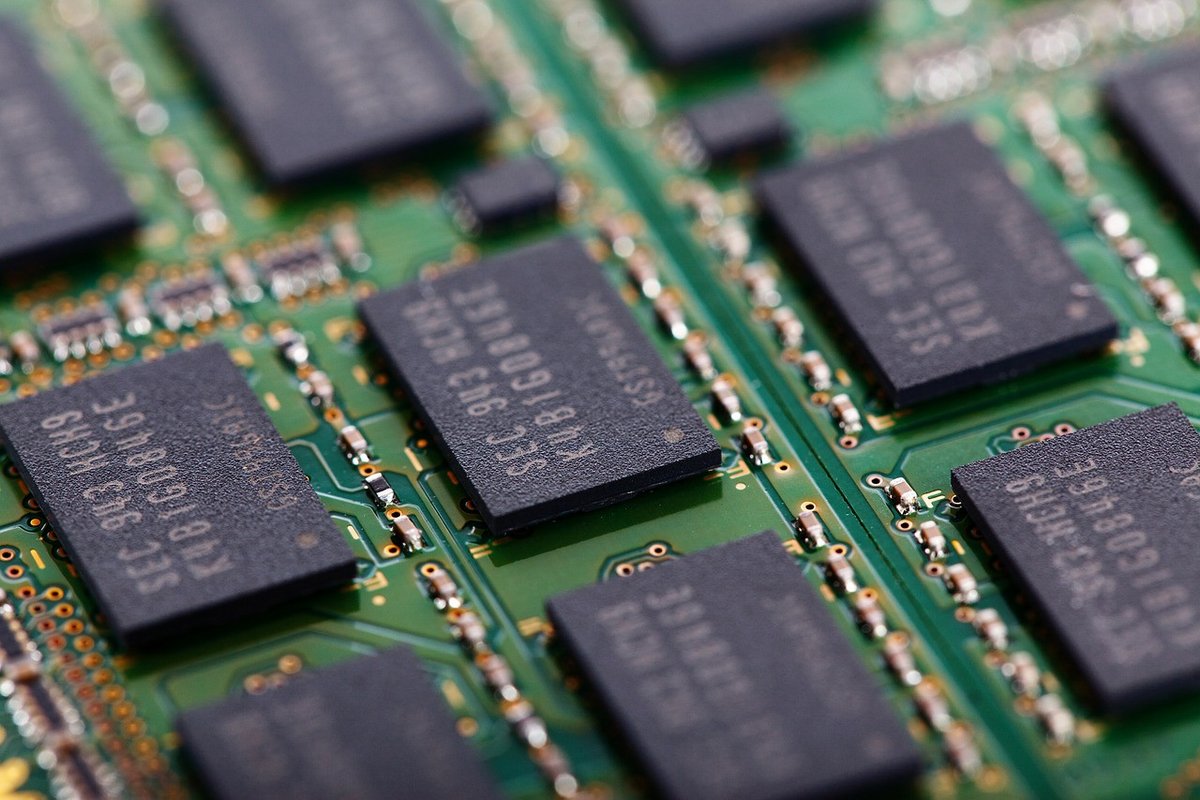

Un nouveau défi se profile à l’horizon pour 2026, déjà marquée par de fortes tensions géopolitiques et commerciales : la pénurie généralisée de mémoire vive, ou RAM (pour Random Access Memory, sans lien avec les Daft Punk). Cette crise structurelle provient d’une réaffectation massive des lignes de production au profit de nos « sacro-saints » modèles de langage (LLM), tels que Gemini ou GPT.

Pour simplifier l’enjeu : les fabricants dégagent des marges bien plus confortables en produisant de la mémoire à très haut débit (HBM) destinée aux datacenters. Cela les incite à délaisser les standards DDR et GDDR qui équipent pourtant nos ordinateurs et consoles. Mécaniquement, cette baisse de l’offre face à une demande constante provoque une explosion des prix.

La problématique s’étend aux cartes graphiques, qui dépendent de la mémoire vidéo, notamment la GDDR7 utilisée par les nouvelles séries RTX 50 et RX 9000. Ces contraintes alimentent même les ragots : NVIDIA pourrait réduire sa production de GPU grand public de 30 à 40 %.

Les consoles ne sont évidemment pas épargnées. Alors que l’on pouvait raisonnablement espérer l’annonce d’une nouvelle génération chez Sony et Microsoft pour 2027 ou 2028, ce calendrier semble aujourd’hui compromis… à moins d’accepter des prix de lancement totalement prohibitifs pour le grand public.

Qu’est-ce que ça change tout ça au final ?

Il est indéniable que notre média traverse une crise matérielle sans précédent. Faut-il pour autant perdre espoir et se contenter de pester contre l’augmentation inéluctable du prix des consoles ? On adore râler, mais l’avenir n’est pas forcément sombre pour autant. Il est, à vrai dire, plus mystérieux qu’il n’y paraît.

Ce constat peut sembler étrange, mais les problématiques évoquées plus haut pourraient paradoxalement favoriser l’émergence de nouvelles pratiques. On peut imaginer que les développeurs (de jeux comme de moteurs graphiques) soient enfin contraints de prioriser l’optimisation. Le marché pourrait également opérer un virage vers des titres plus légers pour nos machines, en misant davantage sur la direction artistique que sur la débauche technique. Qui sait, la longévité de nos appareils actuels s’en verra peut-être même rallongée !

À l’inverse, l’autre face de la pièce existe aussi : un monde où le DLSS prend définitivement le dessus et où le cloud gaming devient la norme (tiens encore NVIDIA), nous affranchissant enfin des contraintes matérielles. Dans ce scénario, les temps de développement pour créer des jeux toujours plus qualitatifs sur un hardware stagnant risquent de s’allonger, bouleversant totalement les modèles économiques traditionnels.

Pour le meilleur ou pour le pire, nous vivons un potentiel tournant majeur de l’histoire du jeu vidéo. Accrochez-vous, car l’année 2026 ne fait que commencer.

Cap sur 2026 et ses colossaux défis éditoriaux

Drakyng

« Nous ne remplaçons pas les artistes » : Larian (Divinity) éteint la polémique sur l’IA

Ninof

Les jeux doivent-ils adopter un nutri-score contre l’utilisation d’IA ?

Sreex